AI行业应用是一片新的大陆,深度学习作为新大陆的基石,经历了一轮又一轮突破。过去十年,在计算机视觉、语音识别、棋类AI等计算和感知智能技术上,深度学习率先取得成功。而最近深度学习在认知智能/自然语言处理上的进展,特别是Transformer衍生模型加上两阶段预训练语言模型范式的成功,正在将自然语言处理变成人工智能下一个最有可能的突破口。

计算机视觉与语音的成功是破茧成蝶而非横空出世

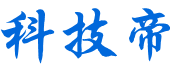

从2010年到2017年,从LeNet到AlexNet到Inception到VGGNet到ResNet及其衍生结构,深度神经网络加上集成学习技术在计算机视觉研究中大放异彩,在ImageNet 大规模深度视觉挑战 (ILSVRC)的图像分类任务上的错误率从28.2%一路降低到了接近2%。尽管这仍然是“实验室环境”下的结果,但当AI在某一个单点任务上的表现接近或者超越人类的时候,就会给行业带来巨大的商机。在视觉分类、检索、匹配、目标检测等各项任务上,随着相关算法越来越准确,业界也开始在大量商业场景中尝试这些商业技术的商用。

人脸识别,作为计算机视觉技术突破带来的代表性应用,就是在这个大背景下从技术进入成熟商业期,爆发成为了一个千亿甚至万亿级别的市场。

但在计算机视觉技术商业化的历程中,其实也有一段不短的蛰伏期。在深度卷积神经网络兴起之前,当年微软亚洲研究院研究人脸识别的团队曾在内部长期遭受质疑:做了十来年,做来做去总是只有百分之六七十、七八十的准确率,看上去挺好玩,但这准确率能有啥实际应用价值呢?然而2010年开始的深度学习浪潮迅速扫清了质疑,而长期研究这个方向的被质疑者们,成了这个新商业领域的领导者,从火种涅槃成为满天繁星。而连接主义学派的忠实信徒、蛰伏近三十年的深度学习三剑客Geoff Hinton, Yann LeCun 和Yoshua Bengio,也是因为有了在统计机器学习盛行的数十年间受尽冷眼的厚积,才有了2010年之后因为GPU算力和神经网络模型不断加深而产生的薄发,从而一举获得图灵奖。

为什么自然语言处理领域的发展要相对滞后?

深度学习在计算机视觉、语音识别等感知智能技术上率先取得成功并不是偶然。深度学习秉承连接主义学派的范式,相较传统统计机器学习技术的最大进化在于其利用了高于统计方法数个数量级的参数和极其复杂的函数组合,通过引入各种非线性和多层级感知能力,构成了远强于统计机器学习模型的拟合能力。ResNet-152的参数量已经达到六千万的级别,GPT-2.0的参数量达到了惊人的15亿。而其他上亿甚至数亿级别的网络更是数不胜数。如此复杂的模型对数据的拟合能力达到了前所未有的水平,但是同时也极大提高了过拟合的风险。这对数据提出了极高的要求。训练数据的数量、维度、采样均衡度、单条数据本身的稠密度(非0、不稀疏的程度),都需要达到极高的水平,才能将过拟合现象降低到可控范围。

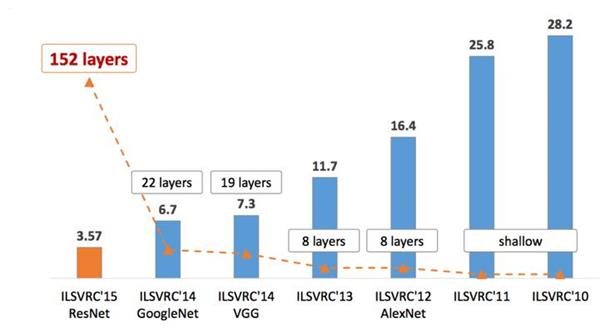

视觉信息(图像、视频)恰好是这样一类自然连续信号:一张图片通常就有数百万甚至上千万像素,而且每个像素上通常都有颜色,数据量大、数据的表示稠密、冗余度也高。往往在丢失大量直接视觉信号的情况下,人还能迅速理解图片的语义信息,就是因为自然连续信号如图像中的场景和物体往往具有视觉、结构和语义上的共性。一个30MB的位图图片能被压缩到2MB而让人眼基本无法感知区别、一个30MB的wave音频文件被压缩到3MB的MP3还能基本保持主要旋律和听感,都是因为这类自然连续信号中存在大量不易被人的感官所感知的冗余。

视觉信息这种的丰富和冗余度,让深度神经网络得以从监督信号中去一层层提炼、一层层感知,最终学会部分判断逻辑。深度神经网络在感知智能阶段中在视觉任务和语音任务上的成功,离不开视觉、语音信号自身的这种数据特点。

今天,归属于感知智能类别的视觉和语音应用已经全面开花,但是属于认知智能的自然语言处理却发展滞后。这种发展状态与自然语言处理的所处理数据的特点也有密不可分的关系。

相对于图片、语音给出的直接信号,文字是一种高阶抽象离散信号。较之图片中的一个像素,文本中的一个单元明显信息密度更大、冗余度更低,往往组成句子的每一个单词、加上单词出现的顺序,才能正确表达出完整的意思。如何利用单个文本元素(字/词)的意思,以及如何利用语句中的顺序信息,构成了近年来自然语言处理和文本分析技术的主要探索脉络。

在2013年词的分布式向量表示(Distributed Representation)出现之前,如何在计算机中高效表示单个字/词就是难以逾越的第一个坎。在只能用One-hot向量来表示字/词的年代,两个近义词的表示之间的关系却完全独立,语义相似度无法计算;上表示一个字/词所需的上万维向量中只有一个维度为1,其他维度都为0,稀疏度极高。面对这类信号,深度神经网络这类复杂的模型所擅长的化繁为简的抽象、提炼、总结能力束手无策,因为输入信号已经极简到了连最基础的自我表示都难以做到。

NLP中的两大重要挑战:特征表示、结构/语义理解正取得关键进展

而分布式词向量将语言的特征表示向前推进了一大步。分布式词向量提出了一个合理的假设:两个词的相似度,可以由他们在多个句子中各自的上下文的相似度去度量,而上下文相似的两个词会在向量空间中由两个接近的向量来表示。这种做法部分赋予了词向量“语义”,因为从此我们不必再让机器去查百科全书告诉我们“苹果”的近义词是“梨子”,而是直接从大量的互联网语料中去学习,原来“苹果”的近义词也可以是“三星”甚至“华为”。因为人们常常会说“我购买了一个苹果手机”,也常说“我购买了一个三星手机”,模型会敏锐的学习到“苹果”和“三星”在大量语料中出现时其上下文高度相似,因而认为两个词相似。分布式词向量让无语义、极稀疏的One-hot向量寿终正寝,而为大家提供了嵌入了语义信息、稠密的特征表示,这才使得深度神经网络在自然语言处理和文本分析上的应用真正变得可能。

捕捉语句中在独立的词集合基础之上的、词序列构成的句子结构信息也是自然语言处理和文本分析中的一个主要方向。传统条件随机场(CRF)考虑了前后相邻元素和当前元素之间的依赖;长短时记忆网络模型(LSTM)以一种衰减形式考虑了当前元素之前的元素序列;seq2seq通过注意力和编解码的机制使得解码时的当前元素不光能用上已经解码完毕的元素序列,还能用上编码前的序列的完整信息;近期各类基于Transformer结构如ELMo 、BERT、GPT-2.0、XLNet,则利用两阶段(基于自编码或是自回归的预训练加基于任务的调优)模式,能够以无监督的方式更好地利用大规模的无标注语料训练不同句子结构中词语之间的关系,并且突破传统线性序列结构中存在的难以建立长距离、双向依赖关系的问题,学习到质量更高的中间语言模型,再通过调优就能在文本生成、阅读理解、文本分类、信息检索、序列标注等多个任务上取得当前最为领先的准确率。

拿机器阅读理解任务来说,在SQuAD1.0数据集上,BERT和XLNet都已大幅超越人类的91.22(F1分),分别达到了93.16和95.08。在更加复杂的SQuAD2.0数据集上,XLNet也已经达到了89.13的F1。

又如在2019年3月举行的第十四届NTCIR上,短文本情感对话任务(STC3)提出的要求是:中文回答不仅需要内容合理,语句流畅,而且需要情感合宜。例如,如果用户说“我的猫昨天去世了”,如果机器人想表达悲伤的情感,那么最合适的回答可能是“这太悲伤了,很抱歉听到”,但如果想表达安慰的情感,则应该说 “坏事永远发生,我希望你会快乐很快“。对情感表达要求的增加,无疑增加了难度。这次比赛中,一览群智和人民大学信息学院联合组成的团队获得了冠军。团队就是使用了基于Transformer的改进网络模型,以情感识别、情感领域对话子模型、集成学习等方法相结合,击败了十几个国际上的强劲对手。类似的探索,让AI在特定任务下的认知能力,朝着人类水平一步步发展。

认知智能进入快车道

自然语言处理虽然比计算机视觉和语音滞后几年,但是我们看到自然语言处理已经进入快车道。近两年来语言模型上的飞速进步,让我们感受到之前制约自然语言处理和文本分析发展的主要难点,正在被更好的模型结构、更好的训练和使用方法、更大的算力逐渐克服。为自然语言任务加入“常识”,也是另一个新兴重要探索方向,这个方向则与知识图谱技术紧密结合。一览群智也正在这个方向上做出探索。

我们也许正处于认知智能的黄金发展期。新技术的出现和逐步成熟,也使得更多的行业应用场景变得可能。一览群智在行业中一直在探索认知智能的基础技术发展和前沿行业应用,围绕自然语言和文本类技术的变与不变,在这个过程中有着自己的思考和总结,并且通过智语这个核心技术产品,向行业给出自己的答案。

“智语” 自然语言处理平台

就像BERT、GPT-2.0、XLNet在两阶段范式上的殊途同归,一览群智认为基础语言模型在不同任务上可以存在一些不变性,但在不同场景中一定要做特殊语料与任务下的调优与适配。出于对文本信号特性的理解和自然语言处理技术发展阶段的清醒认识,从很早开始,一览群智构建认知智能核心产品智语平台的思路,也是围绕这种变与不变在展开。对于基础、不变的部分,BERT、GPT-2.0、XLNet在发布不到72小时内,一览群智便已构建了在一览群智独特语料下的最新语言模型,保证智语平台中的基础语言模型的最先进性。

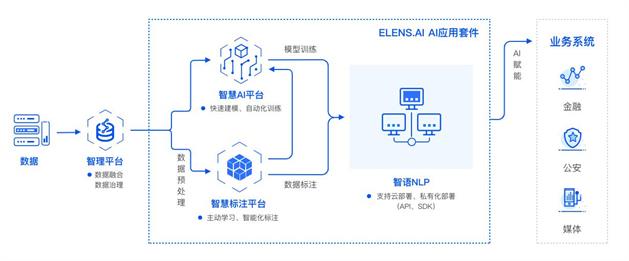

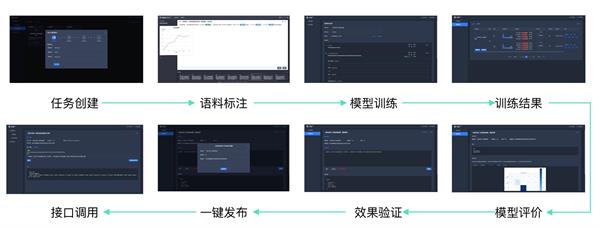

“智语” 自然语言处理平台的智能流程

但认知智能在金融、公安、媒体等场景中的变化部分给AI厂商带来的挑战非常明显。一个媒体场景的10类新闻分类模型,无法去给另一个媒体的12类分类体系使用;通用语料下针对人地组织的命名实体抽取,无法抽取电商行业的产品名或是警情数据中的某些重要信息。一个算法往往在不同场景下要利用不同的标注语料去形成不同的模型。

“智语” 自然语言处理平台端到端流程方案

为了解决数据标注难、封闭环境下模型训练难、部署难等问题,一览群智的智语平台还提供了标注管理、智能标注加速、自然语言处理、文本模型训练、一键部署等端到端功能,大幅提升团队在应对不同场景时的效率和效果。例如智能标注加速功能,利用主动学习的先进技术,将训练一个分类或者序列标注模型的标注量有效降低至原有的30%-50%,而保持模型性能基本不变;加上平台高效能的标注管理,总体效率提升可达数倍。而傻瓜式的训练和部署,使得非常初级的团队成员通过短期培训也能有效形成AI的生产力。通过智语这个核心基础能力和场景化极大提升了一览群智的AI赋能效率。

回顾AI连接主义学派复兴的十年,是一个算法、算力、应用相互促进不断攀升的螺旋梯。在见证ImageNet图像分类错误率从近30%一路降到近2%、见证AlphaGo从击败樊辉到李世石到柯洁之后,我们开始见证基于BERT/GPT-2.0/XLNet在阅读理解任务超越人类。十年后再回顾,会发现今天之于自然语言处理,也许恰如2014年之于人脸识别。

(一览群智CTO 刘家俊)

作者简介:

刘家俊 一览群智 CTO

澳大利亚昆士兰大学博士

人工智能领域知名学者

曾任IBM中国研究院研究员

澳大利亚联邦科学与工业研究组织博后研究员

人工智能与数据方向顶级国际学术会议及期刊PAKDD、ACM MM、IEEE TKDE的程序委员、审稿人

一览群智简介:

一览群智是国内领先的人工智能公司,以自然语言处理和知识图谱等认知智能技术为基础,为客户提供一站式AI产品和行业解决方案。

公司自主研发出智语、智慧、智图、智策四大产品,满足企业在超大规模多源异构情况下的数据治理融合、不同场景下的AI建模,和复杂决策分析需求;让AI技术快速在客户场景落地,打造客户专属的智能决策平台

当前,一览群智的产品和解决方案已经成功应用于中共中央宣传部、中国最高人民检察院、中国建设银行、中国邮政储蓄银行、中信银行等近百家机构,极大的降低了AI应用的门槛,帮助客户实现AI落地。

[责任编辑:快讯]

- 1CAD制作空心字体的方法

- 2如何解决CAD块不能分解的问题

- 3CAD中选择命令的方法总结

- 4为什么说建筑设计师是相亲“杀手”

- 5CAD绘制弯头

- 6CAD绘制指定长度的弧线

- 7CAD中整体覆盖图形的操作方法

- 8能交易比特币的软件有哪些|十大热门比特币

- 9火必网App下载地址(2023最新版)|火必网新手

- 10比特币最新价格行情(实时更新)|比特币B

- 11比特币市值有多少(2023最新版)|比特币总市

- 12比特币BTC今日价格|比特币最新价格美元

- 13火必(Huobi)官网入口|火必官网注册(2023最

- 14比特币最高价格是什么时候|2013-2023比特币历

- 15比特币怎么交易?|交易比特币最新流程(202

- 1CAD制作空心字体的方法

- 2如何解决CAD块不能分解的问题

- 3CAD中选择命令的方法总结

- 4为什么说建筑设计师是相亲“杀手”

- 5CAD绘制弯头

- 6CAD绘制指定长度的弧线

- 7CAD中整体覆盖图形的操作方法

- 8能交易比特币的软件有哪些|十大热门比特币

- 9火必网App下载地址(2023最新版)|火必网新手

- 10比特币最新价格行情(实时更新)|比特币B

- 11比特币市值有多少(2023最新版)|比特币总市

- 12比特币BTC今日价格|比特币最新价格美元

- 13火必(Huobi)官网入口|火必官网注册(2023最

- 14比特币最高价格是什么时候|2013-2023比特币历

- 15比特币怎么交易?|交易比特币最新流程(202